libmdbx (2024-09-27 ... 2025-01-16)

Previous messages

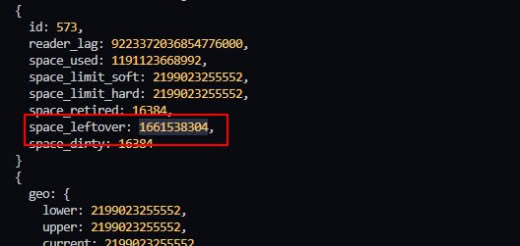

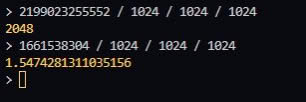

Что-то не догоняю... Почему свободно только 1.5 гб? Максимальный размер бд 2 тб. Занято 1109.32 гб.

Всё, понял... Там для read и write разные...

У меня был сервер Амазона где-то. Могу глянуть как там с bootid (какой там тип фса)

Отмена. Он не контейнерный

These seem to be the correct flags

So, no

27 September 2024

КА

21:06

Кемаль Ататюрк

In reply to this message

it reminds me about constantly open http connection (you can name it transaction) when literally it keeps up and connections stays open using sockets and some data traverse bi-directionally, aka web-sockets, it could potentially cause troubles even if it does not use resources, it still uses a lot of cpu cycles and network resources for no reason. one reason - quick response in milliseconds, cause you do not have a constant http hand shake 3-round algorithm once again every time

L

23:45

Louis

Hello!

I'm using MDBX_APPEND on a table that has MDBX_INTEGERKEY flag: it enforces key insertion in little-endian byte order, which corresponds to the doc that says it adheres to the native byte order.

However, when not using the MDBX_INTEGERKEY flag, then I must encode keys in big-endian, otherwise it fails.

Is this on purpose?

I'm using the rust bindings, I can publish a reproduction example to illustrate if needed.

Thank you!

I'm using MDBX_APPEND on a table that has MDBX_INTEGERKEY flag: it enforces key insertion in little-endian byte order, which corresponds to the doc that says it adheres to the native byte order.

However, when not using the MDBX_INTEGERKEY flag, then I must encode keys in big-endian, otherwise it fails.

Is this on purpose?

I'm using the rust bindings, I can publish a reproduction example to illustrate if needed.

Thank you!

28 September 2024

Л(

00:14

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Without

Next, the

So without

MDBX_INTEGERKEY the keys compared as an octet-strings, i.e. by the memcmp().Next, the

MDBX_APPEND requires (and checks) insertions comes with the keys sort/comparison order.So without

MDBX_INTEGERKEY and with MDBX_APPEND insertions must be comes in ascending order for octet-strings, and this will be done if integer-like keys will be big-endian encoded.

👍

L

L

00:25

Louis

I see! Makes sense, thanks!

🤝

Л(

w

07:53

walter

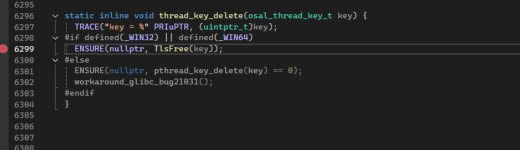

To build for iphone, this patch required:

diff --git a/src/osal.c b/src/osal.c

index d99cd630..71547acd 100644

--- a/src/osal.c

+++ b/src/osal.c

@@ -3512,7 +3512,11 @@ __cold int mdbx_get_sysraminfo(intptr_t *page_size, intptr_t *total_pages,

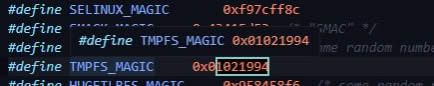

#if __GLIBC_PREREQ(2, 25) defined(__FreeBSD__) defined(__NetBSD__) || \

defined(__BSD__) defined(__bsdi__) defined(__DragonFly__) || \

defined(__APPLE__) || __has_include(<sys/random.h>)

+#ifdef __IPHONE_OS_VERSION_MIN_REQUIRED

+#include <CommonCrypto/CommonRandom.h>

+#else

#include <sys/random.h>

+#endif

#endif /* sys/random.h */

#if defined(_WIN32) || defined(_WIN64)

diff --git a/src/osal.c b/src/osal.c

index d99cd630..71547acd 100644

--- a/src/osal.c

+++ b/src/osal.c

@@ -3512,7 +3512,11 @@ __cold int mdbx_get_sysraminfo(intptr_t *page_size, intptr_t *total_pages,

#if __GLIBC_PREREQ(2, 25) defined(__FreeBSD__) defined(__NetBSD__) || \

defined(__BSD__) defined(__bsdi__) defined(__DragonFly__) || \

defined(__APPLE__) || __has_include(<sys/random.h>)

+#ifdef __IPHONE_OS_VERSION_MIN_REQUIRED

+#include <CommonCrypto/CommonRandom.h>

+#else

#include <sys/random.h>

+#endif

#endif /* sys/random.h */

#if defined(_WIN32) || defined(_WIN64)

👍

vH

КА

🤝

Л(

КА

07:57

Кемаль Ататюрк

commoncrypto/commonrandom.h actually very uncommon anywhere in the world except apple

Л(

07:58

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Thanks.

I will apply+commit this today.

I will apply+commit this today.

🥰

b

w

30 September 2024

Lazymio invited Lazymio

L

13:54

Lazymio

In reply to this message

Hello, may I ask if the values of

DUPSORT is also limited as key size? I can understand the key and subkey should be limited but why does values also have this limitation?

AA

14:18

Alexey Akhunov

In reply to this message

values are also limited to 512 bytes each. as far as I understand, an implemention without limitations is theoretically possible, but it would be more complex. The limitation is inherited from LMDB, I suspect

L

14:19

Lazymio

In reply to this message

I suspect too. This is a bit annoying and makes

DUPSORT less useful

AA

14:24

Alexey Akhunov

long time ago, I have generated some illustrations showing how dupsort values are stored physically in the pages (that was done for LMDB, but it is true for MDBX as well). Check it out: https://github.com/erigontech/erigon/wiki/LMDB-freelist-illustrated-guide#one-dupsort-table-with-a-large-number-of-values-for-one-of-the-keys

14:25

the picture shows 3 cases: for key with a single duplicate values, with 2 duplicate values, and with 1000 duplicate values

14:26

and note this sentence: "This makes DupSort sub-databases "exempt" from the challenges with the freelists that very long values have (due to overflow pages)"

Л(

14:33

Леонид Юрьев (Leonid Yuriev)

In reply to this message

1. dupsort-values (aka multi-values) stored as a keys in a nested b-tree.

2. MDBX store keys in-place on branch/leaf-pages, i.e. a long keys are not placed on separate pages.

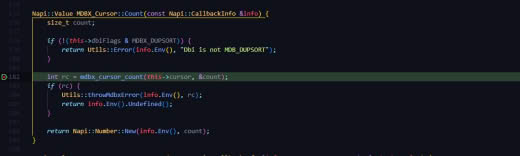

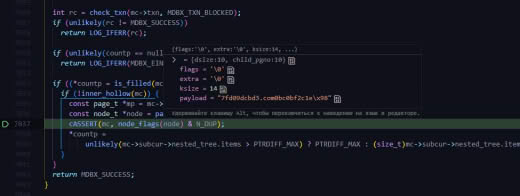

3. see this comment in the code.

2. MDBX store keys in-place on branch/leaf-pages, i.e. a long keys are not placed on separate pages.

3. see this comment in the code.

L

14:34

Lazymio

In reply to this message

Cool, always learned a lot from erigon docs =) Honestly, your dupsort.md in erigon docs is also super helpful. I will have a closer look at the illustrations.

14:35

In reply to this message

That's exactly my question: why not store values elsewhere instead of in leaf nodes (like overflow pages here)? (Reading the docs)

Л(

14:39

Леонид Юрьев (Leonid Yuriev)

In reply to this message

A single-values (i.e. non-dupsort) soread only on a leaf-pages.

But multi-values (aka dupsort values, i.e. the sorted duplicates) stored in a nested b-tree as a keys.

Thus MDBX/MDBX could effective handle a lot-of-millions duplicated/multi-values, which is required for build indices.

But multi-values (aka dupsort values, i.e. the sorted duplicates) stored in a nested b-tree as a keys.

Thus MDBX/MDBX could effective handle a lot-of-millions duplicated/multi-values, which is required for build indices.

L

14:44

Lazymio

In reply to this message

I see. It makes more sense if the intended usage is building indices.

However, (I'm not DB expert so correct me if I'm wrong) why does nested b-tree requires dup values to store as keys? Say, why not the some pointers to larger pages instead of keys?

However, (I'm not DB expert so correct me if I'm wrong) why does nested b-tree requires dup values to store as keys? Say, why not the some pointers to larger pages instead of keys?

14:45

Like the illustrations above, LMDB/MDBX seems to be able to allocate larger pages on demand (?)

П

14:50

Павел

Добрый день! Подскажите, пожалуйста, возможно ли в геомерии задать максимальный размер бд такой, чтоб он автомаически ограничивался лишь физическим размером памяти, т.е. рос до тех пор пока есть место на диске. Сейчас просто подставляю достаточно большое число, но на разных ОС оно разное и приходится иметь логику переоткрытия с меньшими максимальными размерами при получении ошибки по этому поводу.

Л(

14:54

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Я не понимаю что вы спрашиваете. Задавайте размер какой вам требуется. Других вариантов просто не может быть.

СМ

14:59

Сергей Мирянов

я сталкивался примерно с этим при 32х битной сборке - если задать очень большой размер - оно возвращает ошибку. на 64 такого конечно нет (для наших размеров)

но тут мы просто определили максимальный размер для 32 битных версий и его и использовали - что могу посоветовать и Павлу выше

но тут мы просто определили максимальный размер для 32 битных версий и его и использовали - что могу посоветовать и Павлу выше

Л(

15:00

Леонид Юрьев (Leonid Yuriev)

In reply to this message

There are a lot of difficulties with long keys:

- space wasting

- extra memmove/memcpy operation on split/merge/rebalance pages

- extra memcmp for search

- prefix compression should be implemented.

So historically MDBX does not support long keys.

- space wasting

- extra memmove/memcpy operation on split/merge/rebalance pages

- extra memcmp for search

- prefix compression should be implemented.

So historically MDBX does not support long keys.

👍

L

П

15:05

Павел

In reply to this message

На данный момент делаю так:

1) перед окрытием бд вызываю mdbx_env_set_geometry, передавая в size_upper заведомо большое значение (0xFFFFFFFFFFF)

2) пытаюсь открыть бд, выполнив mdbx_env_open

3) проверяю результат. Если он MDBX_TOO_LARGE, то уменьшаю значение максимального размера на порядок, выставляю с ним геомерию и пробую открыть бд еще раз и так по кругу до определенных минимальным значений

Вопрос: Есть ли способ насроить бд так, чтоб максимальное значение автоматически вычислялось/переопределялось по физиеским пределам системы?

1) перед окрытием бд вызываю mdbx_env_set_geometry, передавая в size_upper заведомо большое значение (0xFFFFFFFFFFF)

2) пытаюсь открыть бд, выполнив mdbx_env_open

3) проверяю результат. Если он MDBX_TOO_LARGE, то уменьшаю значение максимального размера на порядок, выставляю с ним геомерию и пробую открыть бд еще раз и так по кругу до определенных минимальным значений

Вопрос: Есть ли способ насроить бд так, чтоб максимальное значение автоматически вычислялось/переопределялось по физиеским пределам системы?

Л(

15:20

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Вы ставите телегу впереди лошади и боретесь с последствиями.

Правильный путь в обратном направлении:

- знать сценарий использования

- понимать какой размер БД нужен для сценария использования

- сформировать требования к системе, включая размер ОЗУ исходя из требуемого размера БД и сценария использования.

На вашем неправильном пути можно дать только пару советов:

- на 32-битных системах реальный максимальный размер БД ограничивается примерно 1 Гб из-за ограничений ОС (правильно сконфигурированный linux позволит использовать до 3 Гб)

- на 64-битных системах вариативность больше, но при размере БД сильно больше ОЗУ могут быть очень большие тормоза из-за больших накладных расходов на поддержку огромных список PTE в ядре ОС.

- можно оттолкнуть от информации получаемой от

Правильный путь в обратном направлении:

- знать сценарий использования

- понимать какой размер БД нужен для сценария использования

- сформировать требования к системе, включая размер ОЗУ исходя из требуемого размера БД и сценария использования.

На вашем неправильном пути можно дать только пару советов:

- на 32-битных системах реальный максимальный размер БД ограничивается примерно 1 Гб из-за ограничений ОС (правильно сконфигурированный linux позволит использовать до 3 Гб)

- на 64-битных системах вариативность больше, но при размере БД сильно больше ОЗУ могут быть очень большие тормоза из-за больших накладных расходов на поддержку огромных список PTE в ядре ОС.

- можно оттолкнуть от информации получаемой от

mdbx_get_sysraminfo().

П

15:29

Павел

In reply to this message

Спасибо за ответ!

В моем случае ожидается постепенный постоянный рост бд. Пару лет спустя размер бд может достигнуть нескольких ТБ.

Но оперативная деятельность с бд идет в оконном режиме, т.е. за определенный период в память может подниматься относительно небольшое количество данных не превышающее размер ОЗУ (редко могут быть обращения за окно.

В моем случае ожидается постепенный постоянный рост бд. Пару лет спустя размер бд может достигнуть нескольких ТБ.

Но оперативная деятельность с бд идет в оконном режиме, т.е. за определенный период в память может подниматься относительно небольшое количество данных не превышающее размер ОЗУ (редко могут быть обращения за окно.

AS

L

AS

18:01

Alex Sharov

In reply to this message

And you want to search values by prefixes (of similar size)? Like: find value by 100kb prefix?

L

18:02

Lazymio

no, the schema is pretty like changeset, I have 80b key, 120b subkey and 0~100kb values

18:02

now I combine the key and subkey together (roughly 200b), dropping

DUPSORT

AS

L

18:04

Lazymio

yeah, yeah, like erigon did, another db for pointer index

18:05

actually I'm indexing logs (as values), and the key and subkey including topics, addresses and some other fields I'm interested

3 October 2024

b

21:29

basiliscos

In reply to this message

да, нет же, просто хотелось бы фишку типа "auto-resize on demand" + возможные политики или хук (типа x2 каждый раз + полная перестройка). Дело в том, что не всегда возможно оценить размеры, иногда это зависит от пользовотельских данных, например от количества файлов - иногда тысячи, а иногда миллиарды, и не хотелось бы эту обязанность по оценке прямо или косвенно делигировать пользователю.

Удобней было бы: "ок, растём в 2 раза", или "растём до такого-то предела", а дальше выдаём ошибку и пользователь сам решает: докупить оперативы или реогранизовать хранилище или ещё что.

Удобней было бы: "ок, растём в 2 раза", или "растём до такого-то предела", а дальше выдаём ошибку и пользователь сам решает: докупить оперативы или реогранизовать хранилище или ещё что.

Л(

21:32

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Вызов callback/hook вместо возврата ошибки при переполнении — принято, это рационально.

👍

EZ

b

4 October 2024

C M invited C M

CM

15:55

C M

anyone knows of any update of MithrilDB ?

6 October 2024

L

14:16

Lazymio

is there any way to replace a key (not value) instead of removing the key and putting the new one?

14:17

or why it is not possible?

L

19:17

Lazymio

Why

https://gitflic.ru/project/erthink/libmdbx/blob?file=src%2Fapi-env.c&branch=master#line-num-659

Does this affect

dont_sync is forced to true here?https://gitflic.ru/project/erthink/libmdbx/blob?file=src%2Fapi-env.c&branch=master#line-num-659

Does this affect

SAFE_NOSYNC ?

Л(

20:04

In reply to this message

If we exclude special cases (when a new key is located in the same position in the sort order, etc.), then replacing a key always requires two operations (deletion and insertion) due to a nature of b-tree.

L

20:05

Lazymio

In reply to this message

Ohhh, you are correct. That makes sense. I forgot the sorting nature of b-tree.

Л(

20:11

Леонид Юрьев (Leonid Yuriev)

In reply to this message

No.

The

1. a env was don't mmaped (when

2. or a env opened read-only (

3. or a env have fatal error ((

4. or a env don't have no a "basal" write-transaction, (i.e. failed to allocate resources, etc).

The

dont_sync = true (i.e. the flag to not-perform sync-to-disk on closing) executed in the following cases:1. a env was don't mmaped (when

env->dxb_mmap.base == nullptr)2. or a env opened read-only (

(env->flags & MDBX_RDONLY) != 0)3. or a env have fatal error ((

(env->flags & ENV_FATAL_ERROR) != 0)4. or a env don't have no a "basal" write-transaction, (i.e. failed to allocate resources, etc).

❤

vH

L

L

20:19

Lazymio

In reply to this message

Ohhhhh, sorry I misunderstood the condition and didn’t notice that the else branch doesn’t have a bracket. Thanks for your patience and detailed explanation.

8 October 2024

Артём Смирнов (студент МФТИ) invited Артём Смирнов (студент МФТИ)

16 October 2024

Всеволод invited Всеволод

KostyaSevastyanov invited KostyaSevastyanov

19 October 2024

A

16:26

Alain

I am looking to build a text search with either an inverted tree or even more likely a Trie. Searching here I found a bit of an answer from a few years ago, about using DUP_SORT for inverted index. I also found a recent reference to Trie that was never built-in and would be a re-write. So just to confirm. inverted index is simple with DUP_SORT and for Trie, no good way to do it with MDBX?

Л(

16:45

Леонид Юрьев (Leonid Yuriev)

In reply to this message

In principle, all this is true, but I am confused by the mention of Trie.

Obviously, it is impossible to build a trie (aka prefix tree) inside a ready-made b-tree implementation, because these are similar, but fundamentally different data structures.

Nonetheless, you can apply a bit of graph theory and store Trie as a set of pairs (parent node -> child node, or vice versa), etc.

Depending on the task/needs/scenario, you can store both nodes directly, links to ones (i.e. node IDs), or combine all this with an admixture of the necessary attributes/features/data.

Obviously, it is impossible to build a trie (aka prefix tree) inside a ready-made b-tree implementation, because these are similar, but fundamentally different data structures.

Nonetheless, you can apply a bit of graph theory and store Trie as a set of pairs (parent node -> child node, or vice versa), etc.

Depending on the task/needs/scenario, you can store both nodes directly, links to ones (i.e. node IDs), or combine all this with an admixture of the necessary attributes/features/data.

vH

17:02

vnvisa.top Hello

In reply to this message

FYI, I am researching this to make inverted index

https://github.com/powturbo/TurboPFor-Integer-Compression/blob/master/lib/idxcr.c

https://github.com/powturbo/TurboPFor-Integer-Compression/blob/master/lib/idxcr.c

20 October 2024

Л(

11:12

Леонид Юрьев (Leonid Yuriev)

In reply to this message

No, this is not safe.

There are only two valid cases with DB on a remove filesystem:

- exclusive mode, i.e. only SINGLE process open/work with a DB on a remove filesystem, no any onthe (i.e. "local") are possible.

- "full" readonly mode, where a several process(es) open/work with a DB on a TRUE READ-ONLY remote filesystem.

The general trouble/issue with a "remote" cases is that a remote process could not aducuate see through it own local address space the updates/writes to DB which performs any other process. Since for a remote processes such updates/writes becomes visible asynchronous and out-of-order because of memory-mapped files nature.

There are only two valid cases with DB on a remove filesystem:

- exclusive mode, i.e. only SINGLE process open/work with a DB on a remove filesystem, no any onthe (i.e. "local") are possible.

- "full" readonly mode, where a several process(es) open/work with a DB on a TRUE READ-ONLY remote filesystem.

The general trouble/issue with a "remote" cases is that a remote process could not aducuate see through it own local address space the updates/writes to DB which performs any other process. Since for a remote processes such updates/writes becomes visible asynchronous and out-of-order because of memory-mapped files nature.

11:14

Thus:

- only single process can write to remote DB, i.e. the MDBX_EXCLUSIVE case.

- no any writes are possible, i.e. the FULL READ-ONLY case.

No options.

- only single process can write to remote DB, i.e. the MDBX_EXCLUSIVE case.

- no any writes are possible, i.e. the FULL READ-ONLY case.

No options.

11:20

In reply to this message

However, this is potentially not safe, as it is possible to violate/bypass checks inside MDBX.

In other words, a reasonable amount of checks is done inside the library, but there is no guarantee that there will not be some way to trick them and open the DB on a remote file system more than once in read-write mode.

+ The main problem here is that there is no simple and reliable way to check whether the database is located on a remote file system. All such checks depend on the system/platform and are quite tedious/time-consuming, etc.

In other words, a reasonable amount of checks is done inside the library, but there is no guarantee that there will not be some way to trick them and open the DB on a remote file system more than once in read-write mode.

+ The main problem here is that there is no simple and reliable way to check whether the database is located on a remote file system. All such checks depend on the system/platform and are quite tedious/time-consuming, etc.

A

12:49

Alain

In reply to this message

Thanks Leonid, I might just use trigram with an inverted index (and here DUPSORT).

🤝

Л(

21 October 2024

kon5t invited kon5t

Л(

18:31

Леонид Юрьев (Leonid Yuriev)

In reply to this message

No!

You should avoid open the same DB twice in a single process.

https://libmdbx.dqdkfa.ru/intro.html#autotoc_md20

You should avoid open the same DB twice in a single process.

https://libmdbx.dqdkfa.ru/intro.html#autotoc_md20

24 October 2024

Л(

22:45

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Рекомендую использовать привязки к Rust от @vorot93.

В reth устаревшая версия mdbx.

В reth устаревшая версия mdbx.

25 October 2024

Л(

07:56

Леонид Юрьев (Leonid Yuriev)

In reply to this message

This is wrong way.

You should use current/actual

Reth break this rules since uses obsolete release with a set of bugs which were fixed (see the Changelog).

Please don't do that.

You should use current/actual

master branch for any development, the last release for staging/testing (and then for production), and later a stable branch when the hive of used release get out to stable phase (i.e. got rid of any feature development but bugfix only).Reth break this rules since uses obsolete release with a set of bugs which were fixed (see the Changelog).

Please don't do that.

08:03

In reply to this message

The database format is frozen, i..e .the DXB-file, but not the LCK-file (which recreates/overwrite each time by the first process opens a DB).

Anyway such a total-break compatibility changes will be noted in the Changelog if this even happens.

Anyway such a total-break compatibility changes will be noted in the Changelog if this even happens.

👍

L

27 October 2024

Л(

13:15

Леонид Юрьев (Leonid Yuriev)

libmdbx 0.12.12 (Доллежаль)

Поддерживающий выпуск с исправлением обнаруженных ошибок и устранением недочетов, в память о советском ученом-энергетике Николае Антоновиче Доллежаль в день 125-летия со дня его рождения.

Это последний выпуск куста стабильных версий 0.12.x, спустя более двух лет после выпуска 0.12.1. Последующие выпуски 0.12.x будут формироваться только в случае существенных проблем/ошибок, вероятность чего близка к нулю. Для всех проектов находящихся в стадии активной разработки рекомендуется использовать ветку master.

https://gitflic.ru/project/erthink/libmdbx/release/1d9b4f5d-1f59-4d92-bcf7-a23b5d3688ab

Поддерживающий выпуск с исправлением обнаруженных ошибок и устранением недочетов, в память о советском ученом-энергетике Николае Антоновиче Доллежаль в день 125-летия со дня его рождения.

Это последний выпуск куста стабильных версий 0.12.x, спустя более двух лет после выпуска 0.12.1. Последующие выпуски 0.12.x будут формироваться только в случае существенных проблем/ошибок, вероятность чего близка к нулю. Для всех проектов находящихся в стадии активной разработки рекомендуется использовать ветку master.

git diff' stat: 6 commits, 5 files changed, 239 insertions(+), 6 deletions(-)https://gitflic.ru/project/erthink/libmdbx/release/1d9b4f5d-1f59-4d92-bcf7-a23b5d3688ab

🔥

A

AS

СМ

4

30 October 2024

5FIDDY invited 5FIDDY

2 November 2024

L

10:04

Lazymio

Are the values of DUP_SORT table sorted? The question seems weird but I observed my values not being sorted.

Л(

L

10:12

Lazymio

In reply to this message

Thanks for the confirmation. I'm running

mdbx_dump to double-check. I observed that the values inserted afterwhile are not sorted when traversing with MDBX_NEXT_DUP. For instance, I inserted 1, 2, 4, 3 and iterating gives exactly 1, 2, 4, 3 but not 1, 2, 3, 4. The key is the same of course.

10:20

In reply to this message

Thanks (again) for quick answering. I found it is due to my key design issue. It is indeed sorted.

3 November 2024

damar invited damar

d

21:17

damar

sorry for the oot, I wanted to know what you guys think about this database and their claims are real?

https://github.com/crossdb-org/crossdb

https://github.com/crossdb-org/crossdb

VS

d

21:35

damar

In reply to this message

no, I just searched for a nonsql database (kv) on github found it, for now I just use LMDB in node.js

КА

d

21:45

damar

In reply to this message

because I only want to use a nosql database for social media bot.

5

21:47

5FIDDY

In reply to this message

mongo, redis, a map/dict/hash{map,set}, loads of options brother

21:49

libmdbx official is only C afaik

d

21:50

damar

In reply to this message

for mongo, redis or other platforms that require installation before use it's not worth it in my case, I just need a ready db when the script is run.

5

21:50

5FIDDY

do you need persistence?

d

5

21:55

5FIDDY

mongo offer a free like 500mb online service no install iirc - if you cant install a db idk many other ways besides saas services to achieve persistence

d

5

d

22:11

damar

In reply to this message

Do you have any other alternative for nonsql databases besides mdb/mdbx? I'm still looking for others that support ACID.

5

22:14

5FIDDY

theres lmdb but idk others besides the ones i mentioned off the top of my head - badger, rocksdb, pebble, tigerbeatle (might be sql idk), p sure those are all acid afaik

22:15

pebble is fastest outside of tigerbeetle afaik (i think that may be sql tho) pebble is good to use

4 November 2024

КА

00:36

Кемаль Ататюрк

In reply to this message

there are no alternatives to mongo, imho. probably considering setup on a vpc with docker + portainer

vH

КА

09:36

Кемаль Ататюрк

In reply to this message

ACID quite hard to implement, imho, keeping in mind CAP theorem. sometimes that worth checking out, sometimes not

d

5 November 2024

КА

08:52

Кемаль Ататюрк

In reply to this message

Thats because Ukrainian terrorists make some comments violating code of conduct or EULA or community rules

8 November 2024

Л(

22:54

Леонид Юрьев (Leonid Yuriev)

В libmdbx удалось устранить/поправить давнюю (но крайне редко проявляющуюся) проблему возврата ошибки

Подробности в комментарии коммита https://gitflic.ru/project/erthink/libmdbx/commit/6c56ed97bbd8ca46abac61886a113ba31e5f1291

Тестирование требует потребует еще минимум недели, а то и двух.

Если недочетов выявлено не будет, то во второй половину будет выпуск libmdbx 0.13.2 и в конце года ветка 0.13.x получит статус стабильной (а 0.12.x отправится в архив).

MDBX_PROBLEM при фиксации транзакций.Подробности в комментарии коммита https://gitflic.ru/project/erthink/libmdbx/commit/6c56ed97bbd8ca46abac61886a113ba31e5f1291

Тестирование требует потребует еще минимум недели, а то и двух.

Если недочетов выявлено не будет, то во второй половину будет выпуск libmdbx 0.13.2 и в конце года ветка 0.13.x получит статус стабильной (а 0.12.x отправится в архив).

👍

w

N

VS

9 November 2024

A

15:25

Alain

A few months ago I made an Infinispan store using MDBX and that has been working fine, but we've noticed that on startup of our application we sometime get an MDBX exception. Our service restarts and finally gets through, but this can cause long startup time and its not correct.

The error is: mdbxjni.Env - Function:mdbx_cursor_close, line:18984, msg:assert: check_txn(txn, 0) == MDBX_SUCCESS

Here is the mdbx_close, where I've underlined the origin:

```

void mdbx_cursor_close(MDBX_cursor *mc) {

if (likely(mc)) {

if (unlikely(mc->mc_signature != MDBX_MC_READY4CLOSE &&

mc->mc_signature != MDBX_MC_LIVE)) {

DEBUG("closing cursor with signature [%d]", mc->mc_signature);

}

ENSURE(NULL, mc->mc_signature == MDBX_MC_LIVE ||

mc->mc_signature == MDBX_MC_READY4CLOSE);

MDBX_txn *const txn = mc->mc_txn;

if (!mc->mc_backup) {

mc->mc_txn = NULL;

/* Unlink from txn, if tracked. */

if (mc->mc_flags & C_UNTRACK) {

ENSURE(txn->mt_env, check_txn(txn, 0) == MDBX_SUCCESS);

MDBX_cursor **prev = &txn->mt_cursors[mc->mc_dbi];

while (*prev && *prev != mc)

prev = &(*prev)->mc_next;

tASSERT(txn, *prev == mc);

*prev = mc->mc_next;

}

mc->mc_signature = 0;

mc->mc_next = mc;

osal_free(mc);

} else {

/* Cursor closed before nested txn ends */

tASSERT(txn, mc->mc_signature == MDBX_MC_LIVE);

ENSURE(txn->mt_env, check_txn_rw(txn, 0) == MDBX_SUCCESS);

mc->mc_signature = MDBX_MC_WAIT4EOT;

}

}

}

```

My question is what can be causing this. The Infinispan framework is using flowables and I suspect that we get a request to close at a time that nothing should be closable yet. So would appreciate insight into the error that might help me avoid it.

Thanks

The error is: mdbxjni.Env - Function:mdbx_cursor_close, line:18984, msg:assert: check_txn(txn, 0) == MDBX_SUCCESS

Here is the mdbx_close, where I've underlined the origin:

```

void mdbx_cursor_close(MDBX_cursor *mc) {

if (likely(mc)) {

if (unlikely(mc->mc_signature != MDBX_MC_READY4CLOSE &&

mc->mc_signature != MDBX_MC_LIVE)) {

DEBUG("closing cursor with signature [%d]", mc->mc_signature);

}

ENSURE(NULL, mc->mc_signature == MDBX_MC_LIVE ||

mc->mc_signature == MDBX_MC_READY4CLOSE);

MDBX_txn *const txn = mc->mc_txn;

if (!mc->mc_backup) {

mc->mc_txn = NULL;

/* Unlink from txn, if tracked. */

if (mc->mc_flags & C_UNTRACK) {

ENSURE(txn->mt_env, check_txn(txn, 0) == MDBX_SUCCESS);

MDBX_cursor **prev = &txn->mt_cursors[mc->mc_dbi];

while (*prev && *prev != mc)

prev = &(*prev)->mc_next;

tASSERT(txn, *prev == mc);

*prev = mc->mc_next;

}

mc->mc_signature = 0;

mc->mc_next = mc;

osal_free(mc);

} else {

/* Cursor closed before nested txn ends */

tASSERT(txn, mc->mc_signature == MDBX_MC_LIVE);

ENSURE(txn->mt_env, check_txn_rw(txn, 0) == MDBX_SUCCESS);

mc->mc_signature = MDBX_MC_WAIT4EOT;

}

}

}

```

My question is what can be causing this. The Infinispan framework is using flowables and I suspect that we get a request to close at a time that nothing should be closable yet. So would appreciate insight into the error that might help me avoid it.

Thanks

10 November 2024

Л(

00:01

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Thank for reporting, I will check/dig this.

Alexander R invited Alexander R

Л(

02:30

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Hm, no idea for now (

I had a suspicion of some kind of recently introduced bug/regression.

So I added a small/trivial test (available in the

--

In short, when closing a cursor, there are two possible cases: either a cursor closes before a transaction is finished, or after.

In first case, when cursor closed before transaction, then shown code fragment checks a transaction object and then detach the given cursor from the linked list within a transaction.

In second case, when transaction terminated while cursor(s) are still live, it unlink all opened/not-closed cursor(s) and clean the C_UNTRACT state-flag each of ones. So later, during closing a cursor, the shown code will bypassed at

In your case a transaction was not terminated and/or at least a cursor(s) still linked within it, but the transaction instance is not valid. Seems like a bug related to handling of cursors linked list, etc.

Please check your case with the current

It is likely someone related bug was fixed.

I had a suspicion of some kind of recently introduced bug/regression.

So I added a small/trivial test (available in the

devel branch), but it just works (on the devel and stable branches both).--

In short, when closing a cursor, there are two possible cases: either a cursor closes before a transaction is finished, or after.

In first case, when cursor closed before transaction, then shown code fragment checks a transaction object and then detach the given cursor from the linked list within a transaction.

In second case, when transaction terminated while cursor(s) are still live, it unlink all opened/not-closed cursor(s) and clean the C_UNTRACT state-flag each of ones. So later, during closing a cursor, the shown code will bypassed at

if (mc->mc_flags & C_UNTRACK).In your case a transaction was not terminated and/or at least a cursor(s) still linked within it, but the transaction instance is not valid. Seems like a bug related to handling of cursors linked list, etc.

Please check your case with the current

stable and/or the master branches.It is likely someone related bug was fixed.

zztopd Zachetnov D. Iv. invited zztopd Zachetnov D. Iv.

A

14:08

Alain

Ok, I will try to add some checks.Like I said this is in a new usage and it happens only (AFAICT) on certain conditions early in the startup stage, almost feels like trying to close something that wasn't fully opened. Also it has been observed in only 2 environments, where the number of such store is larger that the norm. Will keep you posted of what I'm finding

🤝

Л(

vH

15:59

vnvisa.top Hello

What are the required steps to use multiple read_only transactions?

If I make multiple

If I call

If I make multiple

txn_begin calls with parent always NULL, it returned MDBX_BAD_RSLOT: Invalid reuse of reader locktable slot, e.g. read-transaction already run for current threadIf I call

txn_begin with parent is the last successful txn, it returned MDBX_BAD_TXN: Transaction is not valid for requested operation, e.g. had errored and be must aborted, has a child, or is invalid

A

16:04

Alain

In reply to this message

If you look here https://libmdbx.dqdkfa.ru/usage.html#autotoc_md47 it clearly states: "Do not start more than one transaction for a one thread. If you think about this, it's really strange to do something with two data snapshots at once, which may be different. MDBX checks and preventing this by returning corresponding error code (MDBX_TXN_OVERLAPPING, MDBX_BAD_RSLOT, MDBX_BUSY) unless you using MDBX_NOSTICKYTHREADS option on the environment. Nonetheless, with the MDBX_NOSTICKYTHREADS option, you must know exactly what you are doing, otherwise you will get deadlocks or reading an alien data."

👍

vH

Л(

Л(

16:04

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Are you using MDBX_NOSTICKYTHREADS (>= v0.13) or MDBX_NOTLS (< 0.13)?

16:14

In reply to this message

Just in case — are you sure that you don't have a competition/collision between cursor(s) closing and transaction(s) completion in different threads ?

A

16:15

Alain

Sure? Absolutely not and that could in theory very well be the type of issue that I'm facing here.

vH

16:17

vnvisa.top Hello

In reply to this message

I neither use these. Just think it's normal to read_only, becase RO cannot break data.

And maybe MDBX_NOSTICKYTHREADS should be uniqly used for WR txn, doesn't it?

And maybe MDBX_NOSTICKYTHREADS should be uniqly used for WR txn, doesn't it?

Л(

16:20

Леонид Юрьев (Leonid Yuriev)

In reply to this message

A read-only txn(s) needs "locking" of used MVCC-snapshot(s).

So the whole picture is much complex.

So the whole picture is much complex.

16:27

In reply to this message

MDBX_NOTLS is for read-only txns.

MDBX_NOSTICKYTHREADS works like MDBX_NOTLS for read-only txn, but for write-txn disable checking the transaction thread owner.

Please use google-translate (or a similar tool) for the URLs which I given above.

MDBX_NOSTICKYTHREADS works like MDBX_NOTLS for read-only txn, but for write-txn disable checking the transaction thread owner.

Please use google-translate (or a similar tool) for the URLs which I given above.

🆒

vH

13 November 2024

Л(

21:32

Леонид Юрьев (Leonid Yuriev)

Нужна ли поддержка Conan ?

На всякий уточню, что размещение libmdbx в основном Conan-центре не возможно, так как он находится на Github (навечно в черном списке).

На всякий уточню, что размещение libmdbx в основном Conan-центре не возможно, так как он находится на Github (навечно в черном списке).

VS

21:37

Victor Smirnov

И VCpkg, если можно. Последний — децентрализованный. Складывать всё в центральный репозитарий не нужно.

Л(

b

15 November 2024

A

18:06

Alain

In reply to this message

Finally hit the breakpoint, almost taught I had an Heisenberg here. It is a thread issue:

here we see a valid pair of logs followed by the offending one (the other is not shown as after the breakpoint, The one difference with all the others is the thread (non-blocking-thread--p2-t12) being used. Will have to look deeper into this and maybe check with the Infinispan folks about this.

Thanks for your help here, greatly appreciated.

09:42:45.371 [blocking-thread--p3-t2] ::: TRACE o.i.persistence.mdbx.MdbxDbStore - Closing cursor Cursor[Id:1570174338, db:Database [id=21, name=datasegmentdb_19], txn:Transaction [ThreadId=259, Id=836]

09:42:45.371 [blocking-thread--p3-t2] ::: TRACE o.i.persistence.mdbx.MdbxDbStore - Closing transaction Transaction [ThreadId=259, Id=836]

09:42:45.389 [non-blocking-thread--p2-t12] ::: TRACE o.i.persistence.mdbx.MdbxDbStore - Closing cursor Cursor[Id:1324656279, db:Database [id=22, name=datasegmentdb_20], txn:Transaction [ThreadId=259, Id=836]

here we see a valid pair of logs followed by the offending one (the other is not shown as after the breakpoint, The one difference with all the others is the thread (non-blocking-thread--p2-t12) being used. Will have to look deeper into this and maybe check with the Infinispan folks about this.

Thanks for your help here, greatly appreciated.

🤝

Л(

17 November 2024

Ivan invited Ivan

25 November 2024

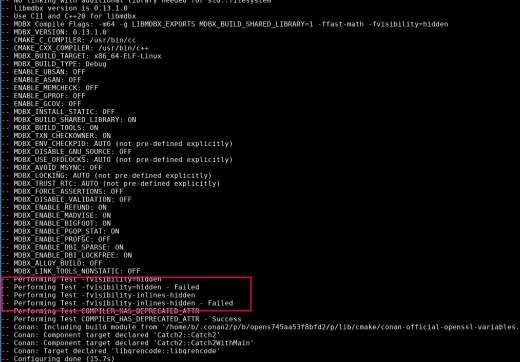

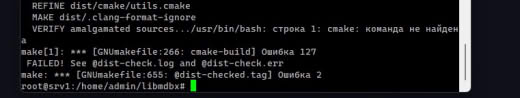

21:23

не подскажете, из-за чего такое может быть? Использую связку conan + cmake, mdbx через FetchContent пробую подключить

Л(

21:25

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Надо в логи CMake при сборке смотреть, иначе никак.

b

21:34

зачем-то

-D пробрасывается.

Л(

21:43

Леонид Юрьев (Leonid Yuriev)

Скорее всего у вас логические ошибки в CMake-скриптах.

b

21:57

basiliscos

если я как

add_subdirectory подключаю, то всё ок. Пока там оставлю.

26 November 2024

Л(

09:38

Леонид Юрьев (Leonid Yuriev)

In reply to this message

запуская

cmake —trace --trace-expand вы точно сможете найти причину появления -D.

b

10:15

basiliscos

In reply to this message

Спасибо. Вот отсюда приезжает: https://github.com/Kitware/CMake/blob/master/Modules/Internal/CheckSourceCompiles.cmake#L110 , если что cmake у меня версии 3.30.1

Л(

10:20

Леонид Юрьев (Leonid Yuriev)

In reply to this message

У вас где-то выше по стеку CMAKE_REQUIRED_DEFINITIONS вместо CMAKE_REQUIRED_FLAGS. Скорее всего в пробнике/проверке проверяющей

-fvisibility.

10:24

Вероятно вместо

check_c_compiler_flag() для проверки -fvisibility ошибочно используется что-то другое.

28 November 2024

professional fish invited professional fish

Л(

11:39

Леонид Юрьев (Leonid Yuriev)

A

Л(

20:14

Леонид Юрьев (Leonid Yuriev)

Ветка

Просьба попробовать.

Если не будет сообщений о недочетах, то в течение нескольких дней будет выпуск.

master на Gitflic готова для выпуска версии 0.13.2.Просьба попробовать.

Если не будет сообщений о недочетах, то в течение нескольких дней будет выпуск.

👍

w

YS

1 December 2024

R invited R

3 December 2024

Л(

09:33

Леонид Юрьев (Leonid Yuriev)

Добавлена поддержка Conan.

Создание пакета сейчас требует GNU Make, так как экспорт исходных текстов в Conan выполняется посредство амальгамирования (

Поэтому

Создание пакета сейчас требует GNU Make, так как экспорт исходных текстов в Conan выполняется посредство амальгамирования (

make dist).Поэтому

conan create пока не работает в Windows, но последующая сборка при использовании пакета конечно работает.

b

10:15

basiliscos

крутяк. А дока есть, как подключить?

Л(

10:25

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Ну это достаточно очевидно, необходимо уметь пользоваться самим conan.

Если без Conan-сервера (с использованием только локального кеша):

- в каталоге с libmdbx выполняете

Если с Conan-серверо:

- в каталоге с libmdbx выполняете

А в целевых/зависимых проектах подключаете libmdbx согласно доке conan.

Если без Conan-сервера (с использованием только локального кеша):

- в каталоге с libmdbx выполняете

conan create .Если с Conan-серверо:

- в каталоге с libmdbx выполняете

conan create ., затем conan upload -r SERVER 'libmdbx/*'А в целевых/зависимых проектах подключаете libmdbx согласно доке conan.

👍

b

b

10:27

basiliscos

я тогда когда релизнется, залью рецепт на конан центер, если не против?

Л(

10:36

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Залить рецепт не проблема, но его потом надо поддерживать.

Т.е. анализировать сообщения/жалобы пользователей, разбираться с ними, обновлять и т.п.

Кроме этого, конан-центр находится на github, а гитхаб уже удалял/блокировал всё и поэтому в черном списке.

Поэтому рецепт на конан-центре никогда не сможет быть поддерживаемым мной, иметь статус "официального" (если так можно сказать).

Т.е. анализировать сообщения/жалобы пользователей, разбираться с ними, обновлять и т.п.

Кроме этого, конан-центр находится на github, а гитхаб уже удалял/блокировал всё и поэтому в черном списке.

Поэтому рецепт на конан-центре никогда не сможет быть поддерживаемым мной, иметь статус "официального" (если так можно сказать).

b

10:39

basiliscos

да, я понял. У меня есть рецепт там уже своей либы, ваш залью со своего аккаунта, неофициальный. По идее ничего сложного. (Хотя проблема с visibility=hidden выше, как раз, возможно, на стыке с конаном пролазит).

Л(

10:40

Леонид Юрьев (Leonid Yuriev)

In reply to this message

С visibility проблема где-то в ваших скриптах, скорее всего.

6 December 2024

Л(

16:47

Леонид Юрьев (Leonid Yuriev)

Для спонсорства/донатов создан Ethereum счет

Все прочие счета давно закрыты и/или не контролируются мной.

Приём средств приостанавливался из-за ухода криптобирж, не-очевидностью путей обналичивания "крипты", декларирования доходов и уплаты налогов.

В текущем понимании, сейчас с этим проблем нет.

0xD104d8f8B2dC312aaD74899F83EBf3EEBDC1EA3A.Все прочие счета давно закрыты и/или не контролируются мной.

Приём средств приостанавливался из-за ухода криптобирж, не-очевидностью путей обналичивания "крипты", декларирования доходов и уплаты налогов.

В текущем понимании, сейчас с этим проблем нет.

7 December 2024

АК

Л(

18:38

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Хм, похоже на регресс, который я уже исправлял. Как-будто коммит потерялся (

Сейчас посмотрю...

Сейчас посмотрю...

АК

18:40

mdbx_stat version 0.13.1.0

- source: v0.13.1-0-g5fc7a6b1 2024-08-30T00:01:07+03:00, commit 5fc7a6b1077794789b97bb2a56f5a4eb541a0bc0, tree 4ad05c5f867a963162def46b68eff5f7130b81ca

- anchor: 4ef6bfc2012bedf4af0bcd644ec87ace207f395c5d5e103573649032ec2cb6e8_v0_13_1_0_g5fc7a6b1

- build: 2024-12-07T18:39:55+0300 for x86_64-linux-gnu by cc (Debian 12.2.0-14) 12.2.0

- flags: MDBX_BUILD_CXX=YES -DNDEBUG=1 -std=gnu++23 -O2 -g -Wall -Werror -Wextra -Wpedantic -ffunction-sections -fPIC -fvisibility=hidden -pthread -Wno-error=attributes -fno-semantic-interposition -Wno-unused-command-line-argument -Wno-tautological-compare -Wl,--gc-sections,-z,relro,-O1 -Wl,--allow-multiple-definition -lstdc++fs -lm -lrt

- options: MDBX_DEBUG=0 MDBX_WORDBITS=64 BYTE_ORDER=LITTLE_ENDIAN MDBX_ENABLE_BIGFOOT=1 MDBX_ENV_CHECKPID=AUTO=0 MDBX_TXN_CHECKOWNER=AUTO=1 MDBX_64BIT_ATOMIC=AUTO=1 MDBX_64BIT_CAS=AUTO=1 MDBX_TRUST_RTC=AUTO=0 MDBX_AVOID_MSYNC=0 MDBX_ENABLE_REFUND=1 MDBX_ENABLE_MADVISE=1 MDBX_ENABLE_MINCORE=1 MDBX_ENABLE_PGOP_STAT=1 MDBX_ENABLE_PROFGC=0 _GNU_SOURCE=YES MDBX_LOCKING=AUTO=2008 MDBX_USE_OFDLOCKS=AUTO=1 MDBX_CACHELINE_SIZE=64 MDBX_CPU_WRITEBACK_INCOHERENT=0 MDBX_MMAP_INCOHERENT_CPU_CACHE=0 MDBX_MMAP_INCOHERENT_FILE_WRITE=0 MDBX_UNALIGNED_OK=8 MDBX_PNL_ASCENDING=0

Л(

18:54

Леонид Юрьев (Leonid Yuriev)

In reply to this message

При рефакторинге потерялся очищающий

Буду выяснять как у меня так получилось.

Поправил в ветке

memset().Буду выяснять как у меня так получилось.

Поправил в ветке

devel, чуть позже пролью в master.

9 December 2024

Алексей Пряников invited Алексей Пряников

10 December 2024

Л(

11:25

Леонид Юрьев (Leonid Yuriev)

libmdbx 0.13.2 will be released this week, most likely tomorrow.

🔥

w

AS

3

👍

SD

2

11 December 2024

Aleksandr Druzhinin invited Aleksandr Druzhinin

Л(

19:17

Леонид Юрьев (Leonid Yuriev)

Упс, с выпуском 0.13.2 техническая ошибка. Через 1-2 часа...

❤

SD

SD

21:21

Sayan J. Das

Hi from India. Is there any way to compile libMDBX without

Thanks.

evex512 optimizations? I can't seem to be able to find any build flag for this. This is really needed as a lot of my users don't have avx512 CPUs.Thanks.

Л(

21:28

Леонид Юрьев (Leonid Yuriev)

In reply to this message

You shouldn't have to worry about that.

Functions with AVX512 / AVX2 / AVX instructions will be used only if the such instructions are supported by the specific processor.

Functions with AVX512 / AVX2 / AVX instructions will be used only if the such instructions are supported by the specific processor.

👍

ЮС

SD

21:31

Sayan J. Das

In reply to this message

Basically I'm writing a Zig binding library to libmdbx (https://github.com/theseyan/lmdbx-zig), so the amalgamated sources are compiled using

I'm fairly sure I'm doing something wrong as trying to compile for a target without

build.zig (this has the advantage of easy cross-compilation).I'm fairly sure I'm doing something wrong as trying to compile for a target without

exev512 support results in a cascade of errors, such as the attached screenshot

21:32

any C definition/macro I should pass from zig to make the feature detection work properly in mdbx?

21:35

(this works perfect if I do build including

evex512 target, but then it doesn't work on any older x86_64 cpu)

21:38

> "-std=gnu11",

"-O2",

"-g",

"-Wall",

"-ffunction-sections",

"-fvisibility=hidden",

"-pthread",

"-Wno-error=attributes",

"-fno-semantic-interposition",

"-Wno-unused-command-line-argument",

"-Wno-tautological-compare",

"-DMDBX_BUILD_FLAGS=\"DNDEBUG=1\"",

"-ULIBMDBX_EXPORTS",

these are the flags passed by Zig (clang)

"-O2",

"-g",

"-Wall",

"-ffunction-sections",

"-fvisibility=hidden",

"-pthread",

"-Wno-error=attributes",

"-fno-semantic-interposition",

"-Wno-unused-command-line-argument",

"-Wno-tautological-compare",

"-DMDBX_BUILD_FLAGS=\"DNDEBUG=1\"",

"-ULIBMDBX_EXPORTS",

these are the flags passed by Zig (clang)

Л(

21:38

Леонид Юрьев (Leonid Yuriev)

In reply to this message

This is a zig toolchain bug, sure.

You could try to build libmdbx with definition

However, I am not sure that this will help, because the compiler may actually not support more other features that it reports as supported.

You could try to build libmdbx with definition

MDBX_HAVE_BUILTIN_CPU_SUPPORTS=0.However, I am not sure that this will help, because the compiler may actually not support more other features that it reports as supported.

SD

21:59

Sayan J. Das

In reply to this message

Using

Also, it seems that on Apple/Bionic devices, optimizations are disabled. I can add that behaviour to

MDBX_HAVE_BUILTIN_CPU_SUPPORTS=0, the build seems to work! But drawback seems that on x86/x64 the optimizations will be disabled. If I compile with evex512 in build.zig with this flag, will AVX512 optimizations work on a supported device?Also, it seems that on Apple/Bionic devices, optimizations are disabled. I can add that behaviour to

build.zig

SD

22:19

Sayan J. Das

You are right, this is a zig compiler regression (https://github.com/ziglang/zig/issues/20414)

АК

22:26

Алексей (Keller) Костюк 😐

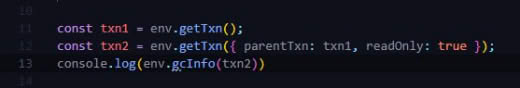

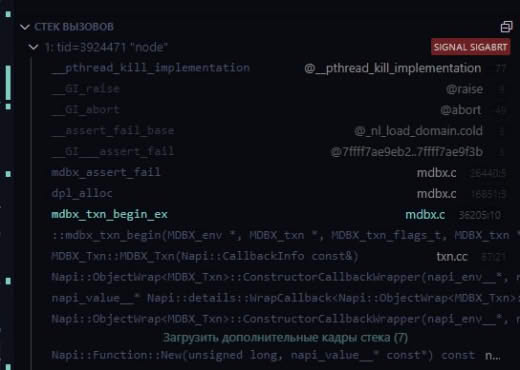

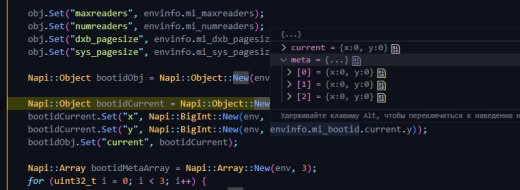

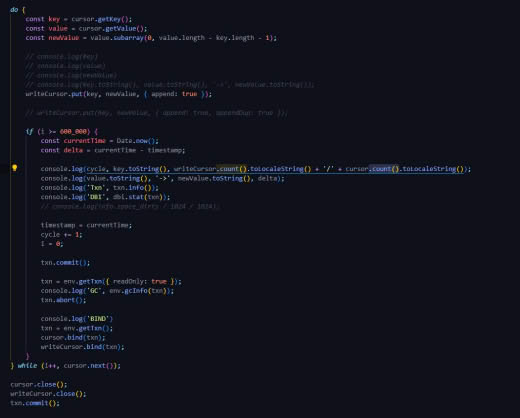

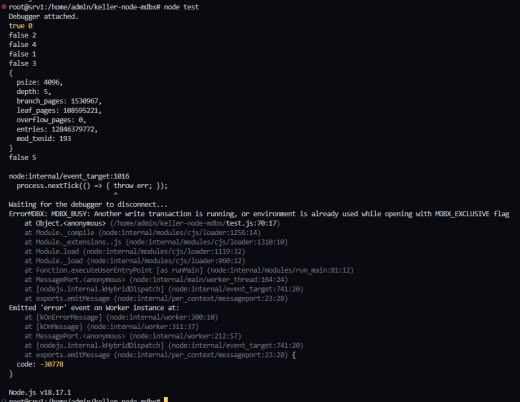

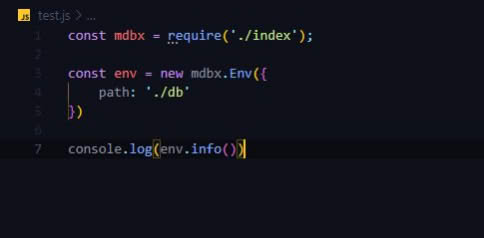

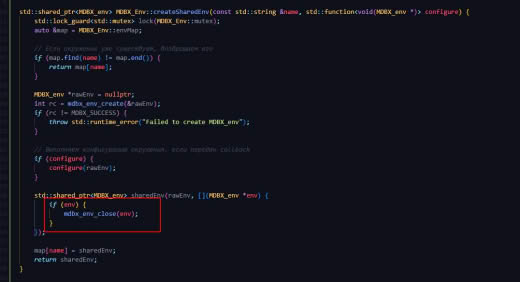

@erthink Леонид здравствуйте. Пытаюсь реализовать вложенные транзакции, но получаю:

MDBX_BAD_TXN: Transaction is not valid for requested operation, e.g. had errored and be must aborted, has a child, or is invalid

Не подскажите, в чём может быть проблема?

MDBX_BAD_TXN: Transaction is not valid for requested operation, e.g. had errored and be must aborted, has a child, or is invalid

Не подскажите, в чём может быть проблема?

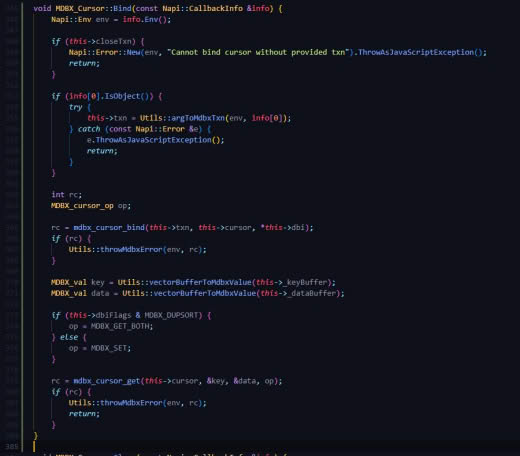

MDBX_Txn::MDBX_Txn(const Napi::CallbackInfo &info) : Napi::ObjectWrap<MDBX_Txn>(info) {

unsigned int envFlags;

unsigned int txnFlags = MDBX_TXN_READWRITE;

int rc;

MDBX_txn *parentTxn = nullptr;

MDBX_env *env = info[0].As<Napi::External<MDBX_env>>().Data();

// MDBX_Txn parentTxn = info[1].As<Napi::External<MDBX_Txn>>().Data();

rc = mdbx_env_get_flags(env, &envFlags);

if (rc) {

Utils::throwMdbxError(info.Env(), rc);

return;

}

if (envFlags & MDBX_RDONLY) {

txnFlags = MDBX_TXN_RDONLY;

}

if (info[1].IsObject()) {

Napi::Object options = info[1].ToObject();

Utils::setFromObject(&txnFlags, MDBX_TXN_RDONLY, options, "readOnly");

Utils::setFromObject(&txnFlags, MDBX_TXN_RDONLY_PREPARE, options, "prepare");

Utils::setFromObject(&txnFlags, MDBX_TXN_TRY, options, "try");

Utils::setFromObject(&txnFlags, MDBX_TXN_NOMETASYNC, options, "noMetaSync");

Utils::setFromObject(&txnFlags, MDBX_TXN_NOSYNC, options, "noSync");

Napi::Value parentTxnValue = options.Get("parentTxn");

if (parentTxnValue.IsObject()) {

Napi::Object parentTxnObj = parentTxnValue.ToObject();

if (parentTxnObj.InstanceOf(MDBX_Txn::constructor.Value())) {

// MDBX_Txn *parentTxnClass = parentTxnValue.As<Napi::External<MDBX_Txn>>().Data();

MDBX_Txn *parentTxnClass = Napi::ObjectWrap<MDBX_Txn>::Unwrap(parentTxnObj);

parentTxn = parentTxnClass->txn;

} else {

Napi::TypeError::New(info.Env(), "Invalid parentTxn: not an instance of Txn").ThrowAsJavaScriptException();

return;

}

}

}

rc = mdbx_txn_begin(env, parentTxn, static_cast<MDBX_txn_flags>(txnFlags), &this->txn);

if (rc) {

Utils::throwMdbxError(info.Env(), rc);

return;

}

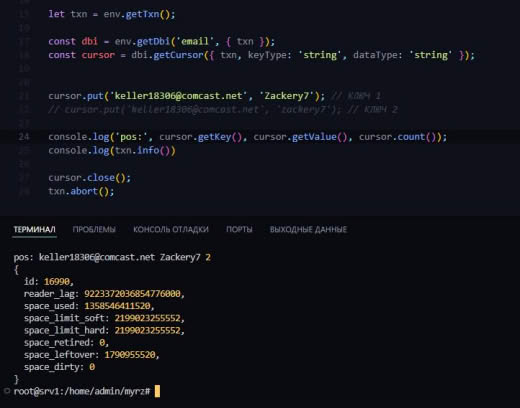

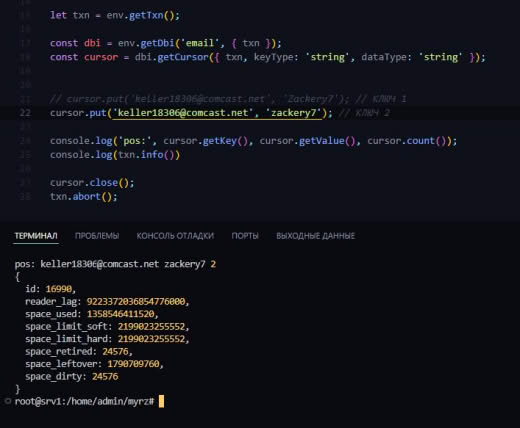

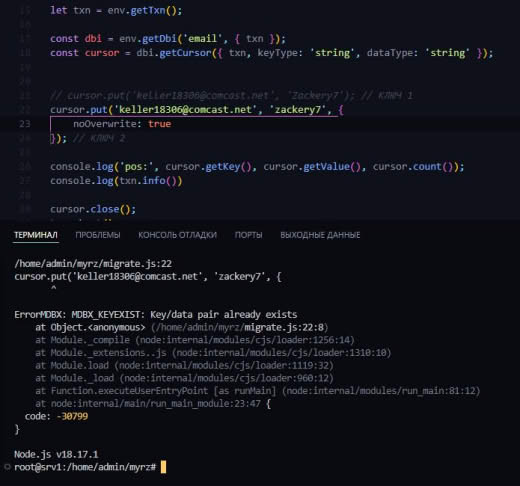

}const txn1 = env.getTxn();

const txn2 = env.getTxn({

parentTxn: txn1

});

console.log(txn2.info())

txn1.abort();

Л(

22:29

Леонид Юрьев (Leonid Yuriev)

In reply to this message

На вскидку — вложенные транзакции только пишущие, read-only вложенными быть не могут.

АК

22:29

Алексей (Keller) Костюк 😐

In reply to this message

Ааа... Не знал... Спасибо

А как тогда несколько открыть для чтения?

Получаю:

MDBX_BAD_RSLOT: Invalid reuse of reader locktable slot, e.g. read-transaction already run for current thread

А как тогда несколько открыть для чтения?

Получаю:

MDBX_BAD_RSLOT: Invalid reuse of reader locktable slot, e.g. read-transaction already run for current thread

Л(

22:30

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Ну доку прочитать для начала )

+ А еще важно понимать зачем вам несколько read-only тразнакций и как они будут связаны с тредами

+ А еще важно понимать зачем вам несколько read-only тразнакций и как они будут связаны с тредами

АК

22:33

А ну вроде нашёл что-то:

One thread - One transaction

A thread can only use one transaction at a time, plus any nested read-write transactions in the non-writemap mode. Each transaction belongs to one thread. The MDBX_NOSTICKYTHREADS flag changes this, see below.

Do not start more than one transaction for a one thread. If you think about this, it's really strange to do something with two data snapshots at once, which may be different. MDBX checks and preventing this by returning corresponding error code (MDBX_TXN_OVERLAPPING, MDBX_BAD_RSLOT, MDBX_BUSY) unless you using MDBX_NOSTICKYTHREADS option on the environment. Nonetheless, with the MDBX_NOSTICKYTHREADS option, you must know exactly what you are doing, otherwise you will get deadlocks or reading an alien data.

One thread - One transaction

A thread can only use one transaction at a time, plus any nested read-write transactions in the non-writemap mode. Each transaction belongs to one thread. The MDBX_NOSTICKYTHREADS flag changes this, see below.

Do not start more than one transaction for a one thread. If you think about this, it's really strange to do something with two data snapshots at once, which may be different. MDBX checks and preventing this by returning corresponding error code (MDBX_TXN_OVERLAPPING, MDBX_BAD_RSLOT, MDBX_BUSY) unless you using MDBX_NOSTICKYTHREADS option on the environment. Nonetheless, with the MDBX_NOSTICKYTHREADS option, you must know exactly what you are doing, otherwise you will get deadlocks or reading an alien data.

👍

Л(

Л(

22:42

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Apple/Bionic toolchains also have similar bugs (at least some versions) with

The main problem is that design of

__builtin_cpu_supports().The main problem is that design of

__builtin_cpu_supports() feature requires support both from compiler and libc.

22:45

In reply to this message

В LMDB что-то не проверяется, что-то просто не работает и/или падает в подобных ситуациях неверного использования API.

Кроме этого, есть опция

Кроме этого, есть опция

MDB_NOTLS которая во многом аналогична MDBX_NOSTICKYTHREADS.

❤

АК

Л(

23:17

Леонид Юрьев (Leonid Yuriev)

libmdbx 0.13.2 "Прошлогодний Снег" (Last Year's Snow)

Поддерживающий выпуск с исправлением обнаруженных ошибок и устранением недочетов в день рождения и в память об Алекса́ндре Миха́йловиче Тата́рском, российском режиссёре-мультипликаторе, создавшем такие знаменитые мультфильмы как “Падал прошлогодний снег”, “Пластилиновая ворона”, заставку “Спокойной ночи, малыши!” и многие другие шедевры нашего детства.

The support release on the birthday and in memory of Alexander Mikhailovich Tatarsky, the Russian director-animator who created such famous cartoons as “Last Year's Snow Was Falling”, “Plasticine Crow”, the splash of “Good night, kids!” and many other masterpieces of our childhood.

https://gitflic.ru/project/erthink/libmdbx/release/6a1bfb7d-3192-4315-8d3f-d1b95a614bd3

Поддерживающий выпуск с исправлением обнаруженных ошибок и устранением недочетов в день рождения и в память об Алекса́ндре Миха́йловиче Тата́рском, российском режиссёре-мультипликаторе, создавшем такие знаменитые мультфильмы как “Падал прошлогодний снег”, “Пластилиновая ворона”, заставку “Спокойной ночи, малыши!” и многие другие шедевры нашего детства.

151 files changed, 10647 insertions(+), 14952 deletions(-)The support release on the birthday and in memory of Alexander Mikhailovich Tatarsky, the Russian director-animator who created such famous cartoons as “Last Year's Snow Was Falling”, “Plasticine Crow”, the splash of “Good night, kids!” and many other masterpieces of our childhood.

https://gitflic.ru/project/erthink/libmdbx/release/6a1bfb7d-3192-4315-8d3f-d1b95a614bd3

👍

A

e

8

🔥

2

❤

e

12 December 2024

SD

15:43

Sayan J. Das

In reply to this message

Is it possible to add ability to disable SSE2/AVX2/AVX512 optimizations individually using some flags like

MDBX_DISABLE_SSE2=1?

Л(

15:55

Леонид Юрьев (Leonid Yuriev)

In reply to this message

No.

For this purpose, the source code already uses conditional C-preprocessor directives that check the definition of specific macros (

if a compiler predefines such macros, but fails to compile corresponding code, then it is terribly broken.

For this purpose, the source code already uses conditional C-preprocessor directives that check the definition of specific macros (

__AVX512BW__, __ AVX2__, __SSE2__, __ARM_NEON__).if a compiler predefines such macros, but fails to compile corresponding code, then it is terribly broken.

👍

SD

vH

16:25

vnvisa.top Hello

In reply to this message

Could you give a try in terminal

export CC=/usr/bin/clang before compiling?

SD

16:47

Sayan J. Das

In reply to this message

clang and gcc don't have this problem, only zig since 0.13 (even though zig internally uses clang)

16:48

One way to work around is to compile object with clang then link with Zig, but I think I will rather wait until zig compiler is fixed.

16:49

For now, I disable SIMD completely as workaround..

Л(

16:50

Леонид Юрьев (Leonid Yuriev)

In reply to this message

You could try to undefine pre-refined macros by cli-options, i.e. pass the

-U__AVX512BW__ -U__AVX2__ -U__SSE2__ -U__ARM_NEON__ to zig compiler.

SD

17:39

Sayan J. Das

In reply to this message

I tried this, but doesn't seem to work. It's no problem though, will wait for Zig fix upstream. 👍

🤝

Л(

SD

22:38

Sayan J. Das

In the docs, it's stated that in

> This may be slightly faster for DBs that fit entirely in RAM, but is slower for DBs larger than RAM.

however, I was reading the chat history, and it was previously stated that for 1TB database and 16 GiB ram (DB much larger than ram), the writemap mode almost doubles performance, depending on transaction size.

MDBX_WRITEMAP mode,> This may be slightly faster for DBs that fit entirely in RAM, but is slower for DBs larger than RAM.

however, I was reading the chat history, and it was previously stated that for 1TB database and 16 GiB ram (DB much larger than ram), the writemap mode almost doubles performance, depending on transaction size.

22:39

I understand that WRITEMAP allows to easily corrupt the database with stray pointer writes, but is there any more drawback?

Please clarify.

Please clarify.

👍

ЮС

Л(

23:18

Леонид Юрьев (Leonid Yuriev)

In reply to this message

This is highly depends on OS kernel and a whole use case' picture.

In non-MDBX_WRITEMAP mode, or in MDBX_WRITEMAP but when libmdbx build with MDBX_AVOID_MSYNC=ON, libmdbx will track dirty pages and spill/oust ones when reached the

Elsewise an OS kernel will do the same (i.e. track dirty/modified pages in LRU-manner and swap-out oldest ones to disk).

However, libmdbx performs very precise tracking and outs only pages strictly to LRU-policy, whereas the OS kernel can only perform primitive/rough tracking, or even swap-out random pages.

In non-MDBX_WRITEMAP mode, or in MDBX_WRITEMAP but when libmdbx build with MDBX_AVOID_MSYNC=ON, libmdbx will track dirty pages and spill/oust ones when reached the

MDBX_opt_txn_dp_limit.Elsewise an OS kernel will do the same (i.e. track dirty/modified pages in LRU-manner and swap-out oldest ones to disk).

However, libmdbx performs very precise tracking and outs only pages strictly to LRU-policy, whereas the OS kernel can only perform primitive/rough tracking, or even swap-out random pages.

23:28

In reply to this message

Yes, MDBX_WRITEMAP mode is more dangerous.

However, you should rationally consider a risks, but not panic.

For instance, if pointers are used incorrectly, you always have a chance to corrupt a database, even in non-MDBX_WRITEMAP mode:

- it is possible to corrupt a dirty page in-memory before it will written to a DB file;

- it is possible to corrupt in memory an one of internal libmdbx structure;

- etc.

However, you should rationally consider a risks, but not panic.

For instance, if pointers are used incorrectly, you always have a chance to corrupt a database, even in non-MDBX_WRITEMAP mode:

- it is possible to corrupt a dirty page in-memory before it will written to a DB file;

- it is possible to corrupt in memory an one of internal libmdbx structure;

- etc.

13 December 2024

АК

00:27

Алексей (Keller) Костюк 😐

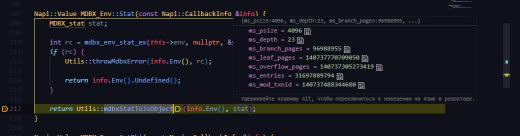

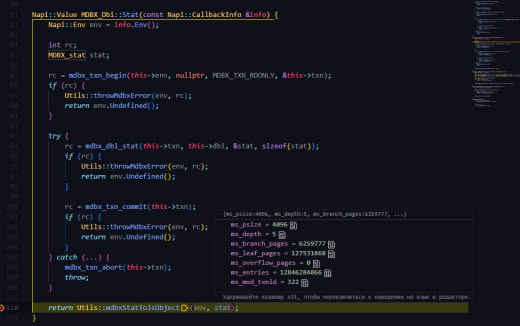

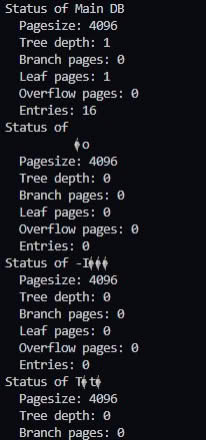

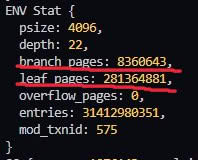

@erthink здравствуйте ещё раз. Почему env.stat выдаёт "плюсованные" значения, когда в теории должно данные для корневой бд выдавать, аналогично LMDB... Или в этом плане MDBX поменяла логику env?

Вы не подумайте, что я как-то принижаю ваши заслуги)) Просто сейчас постепенно внедряю вашу БД, вытесняя LMDB, находя такие несостыковочки :)

Вы не подумайте, что я как-то принижаю ваши заслуги)) Просто сейчас постепенно внедряю вашу БД, вытесняя LMDB, находя такие несостыковочки :)

Л(

00:33

Леонид Юрьев (Leonid Yuriev)

In reply to this message

mdbx_env_stat() выдает информацию по _всей_ БД, поэтому суммирование тут вполне логично.

А для получения информации о первичной таблице следует использовать mdbx_dbi_stat(dbi = 1).

А для получения информации о первичной таблице следует использовать mdbx_dbi_stat(dbi = 1).

00:40

Как в LMDB откровенно не помню, но в API исходно было много самых разных "моментов".

Какие-то первые правки/доработки в 2014 я делал просто по-месту, по сиюминутной необходимости.

Тогда еще не планировалось (вообще не предполагалось) что будет некий сильно развитый fork, и часть этих первых доработок было сделано как было нужно/удобнее для ReOpenLDAP и/или МегаФона, без оглядки на какую-либо совместимость с LMDB.

А уже после это нельзя было менять, чтобы не сломать что-то в МегаФоне.

Поэтому подобные расхождения есть, но мало, если это не единственное.

Как-то так.

Какие-то первые правки/доработки в 2014 я делал просто по-месту, по сиюминутной необходимости.

Тогда еще не планировалось (вообще не предполагалось) что будет некий сильно развитый fork, и часть этих первых доработок было сделано как было нужно/удобнее для ReOpenLDAP и/или МегаФона, без оглядки на какую-либо совместимость с LMDB.

А уже после это нельзя было менять, чтобы не сломать что-то в МегаФоне.

Поэтому подобные расхождения есть, но мало, если это не единственное.

Как-то так.

❤

АК

АК

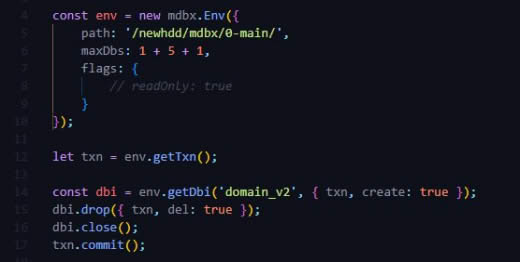

01:36

Алексей (Keller) Костюк 😐

@erthink возникла проблемка :)

Случайно создал мусорные бд, и имена содержат рандом (проиграл видимо в поинтеры и c_str...) По имени оно их не находит, если брать из курсора и прокидывать в mdbx_dbi_open... Как можно удалить бы их?

Случайно создал мусорные бд, и имена содержат рандом (проиграл видимо в поинтеры и c_str...) По имени оно их не находит, если брать из курсора и прокидывать в mdbx_dbi_open... Как можно удалить бы их?

Л(

01:37

Леонид Юрьев (Leonid Yuriev)

In reply to this message

В API есть функции удаления принимающие имена в MDBX_val и std::string_view в C++ API.

АК

01:37

Алексей (Keller) Костюк 😐

Ммм... Спасибо

АК

АК

Л(

07:37

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Вложенность транзакций поддерживается только для пишущих транзакций, уже писал про это.

Если при попытке запустить вложенную транзакцию с MDBX_TXN_RDONLY не возвращается ошибка, то это какой-то регресс — посмотрю.

Если при попытке запустить вложенную транзакцию с MDBX_TXN_RDONLY не возвращается ошибка, то это какой-то регресс — посмотрю.

АК

07:38

Алексей (Keller) Костюк 😐

In reply to this message

А как создать курсор для gc таблицы тогда? Придётся завершить текущую и отдельно открывать только для чтения?

Л(

07:41

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Никак.

GC — это внутренняя структура и к ней не надо обращаться в пишущей транзакции.

Связанное с этим поведение уже менялось и может поменяться еще.

GC — это внутренняя структура и к ней не надо обращаться в пишущей транзакции.

Связанное с этим поведение уже менялось и может поменяться еще.

АК

07:42

Алексей (Keller) Костюк 😐

In reply to this message

Просто у нас в графану статистика пишется по "свободному" месту. Кроме, как из GC, её больше нигде не взять же?

Л(

07:46

Леонид Юрьев (Leonid Yuriev)

In reply to this message

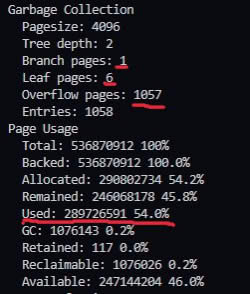

Вот совсем не надо гланды через Ж доставать...

Есть

Есть не задаваться целью проверить корректность использования страницы (отсутствие потерянных или использованных более одного раза), то объем страниц в GC проще посчитать как разницу между выделенными и использованными страницами.

Есть

mdbx_txn_info(), а для получения объема GC не следует её читать — это может быть очень накладно в экстремальных случаях.Есть не задаваться целью проверить корректность использования страницы (отсутствие потерянных или использованных более одного раза), то объем страниц в GC проще посчитать как разницу между выделенными и использованными страницами.

АК

08:20

Алексей (Keller) Костюк 😐

In reply to this message

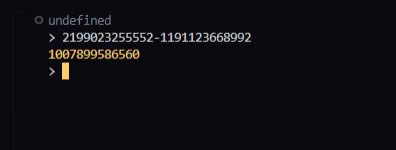

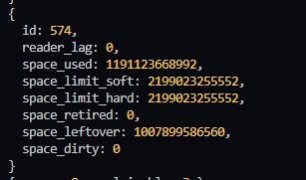

Всё, понял... Там для read и write разные...

08:28

Так это просто вывод "макс размер"-"последняя занятая"...

08:29

Получается, если удалить всё из бд, то это значение не изменится... Ведь не учитываются таблицы на переработку...

Л(

08:33

Леонид Юрьев (Leonid Yuriev)

Не только.

В leftover не входит GC, там только не-распределенные страницы.

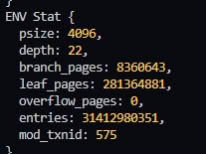

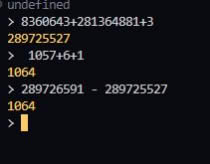

Чтобы получить полный свободный размер (с учетом переработки GC) нужно из space_used вычесть размер всех таблиц и 3 мета-страницы.

См вывод

В leftover не входит GC, там только не-распределенные страницы.

Чтобы получить полный свободный размер (с учетом переработки GC) нужно из space_used вычесть размер всех таблиц и 3 мета-страницы.

См вывод

mdbx_stat -ef / mdbx_chk -vvv и соответствующий исходный код.

АК

08:42

Алексей (Keller) Костюк 😐

In reply to this message

Вроде почти совпало... Но куда-то одна таблица подевалась... Не то, чтобы я сильно её ищу, но всё же)

Л(

10:51

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Что именно у вас потерялось и почему вы так считаете — не понятно.

Но если есть сомнения, то сравните полученные значения с выводом

Но если есть сомнения, то сравните полученные значения с выводом

mdbx_chk -vvv и/или mdbx_stat -efa.

Л(

12:09

Леонид Юрьев (Leonid Yuriev)

In reply to this message

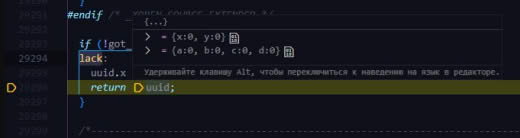

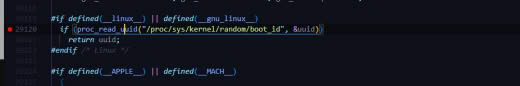

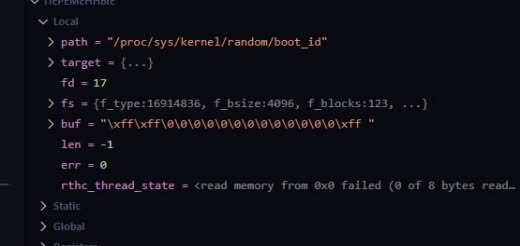

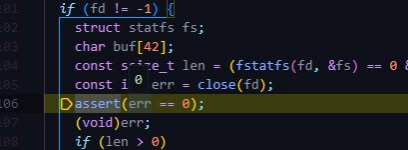

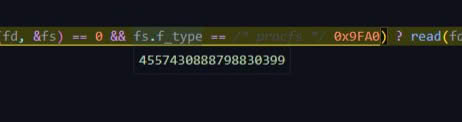

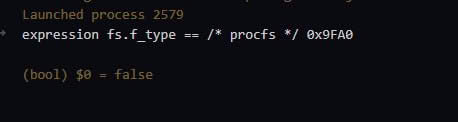

Еще крайне странно, что у вас нет bootid. Это явный признай какой-то ошибки и/или проблемы.

SD

12:13

Sayan J. Das

In reply to this message

Okay, so when DB size exceeds RAM, and

Am I correct?

MDBX_WRITEMAP enabled, then OS will be responsible for swapping which is not accurate as libmdbx itself; and that's why the performance may suffer. But as long as DB can fit in memory, swapping out is minimal so WRITEMAP reduces overhead of tracking pages, etc and hence improves performance.Am I correct?

Л(

SD

12:14

Sayan J. Das

i.e I should enable WRITEMAP considering the 1. risk of corrupting DB and 2. reduction of performance in big DB scenarios

Л(

12:28

In reply to this message

Nonetheless, some clarification about performance.

Depending on the operating system, database size, and usage scenario, enabling MDBX_WRITEMAP can both increase or decrease performance.

In most cases, performance is higher using MDBX_WRITEMAP, but there is no universal rule here.

Here are some factors:

- Windows has very poor performance of msync(), i.e.

- on OpenBSD actually MDBX_WRITEMAP is required, since no unified page cache in the OS kernel;

- on many system/kernels performance my degrade in large-DB cases because of scanning large PTE-tables and/or rough LRU-tracking;

+ in large-update cases it is to hard predict/estimate what is will be faster/cheaper: a file I/O and shadowed update of page cache chained to mmap-region, or a scanning of large PTE-tables with LRU-eviction of dirty-pages.

Depending on the operating system, database size, and usage scenario, enabling MDBX_WRITEMAP can both increase or decrease performance.

In most cases, performance is higher using MDBX_WRITEMAP, but there is no universal rule here.

Here are some factors:

- Windows has very poor performance of msync(), i.e.

FlushViewOfFile();- on OpenBSD actually MDBX_WRITEMAP is required, since no unified page cache in the OS kernel;

- on many system/kernels performance my degrade in large-DB cases because of scanning large PTE-tables and/or rough LRU-tracking;

+ in large-update cases it is to hard predict/estimate what is will be faster/cheaper: a file I/O and shadowed update of page cache chained to mmap-region, or a scanning of large PTE-tables with LRU-eviction of dirty-pages.

Andrew Ashikhmin invited Andrew Ashikhmin

Milen Filatov invited Milen Filatov

SD

14:31

Sayan J. Das

In reply to this message

Thanks for the explanation. 👍

In my case, I'm building a general purpose document DB using libmdbx, where the value sizes can range anywhere from 100 bytes to 16 KiB per record. So I decided to use 8 KiB as pagesize.

From this discussion, it's clear that it might not be worth it to enable WRITEMAP as I intend to support few terabytes size of DB.

In my case, I'm building a general purpose document DB using libmdbx, where the value sizes can range anywhere from 100 bytes to 16 KiB per record. So I decided to use 8 KiB as pagesize.

From this discussion, it's clear that it might not be worth it to enable WRITEMAP as I intend to support few terabytes size of DB.

vH

15:42

vnvisa.top Hello

In reply to this message

It would be great if you have time to benchmark your terabytes size of DB with and without WRITEMAP.

👍

SD

АК

17:26

Алексей (Keller) Костюк 😐

In reply to this message

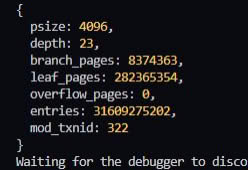

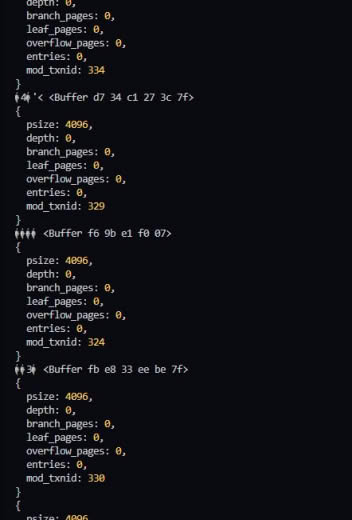

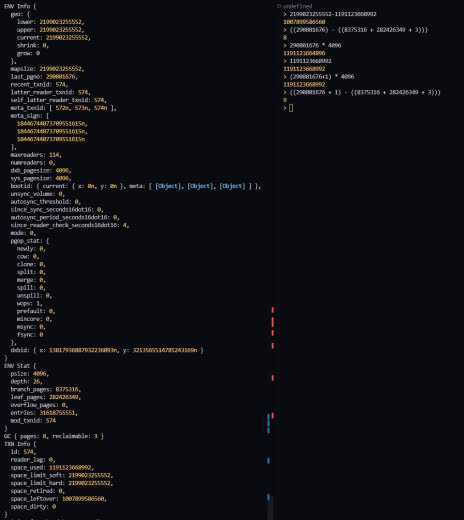

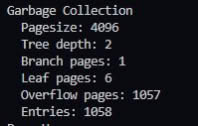

В gc 8 таблиц, когда у меня после вычислений получается 9

Если сплюсовать env.branch_pages+env.leaf_pages+3 и сравнить с mdbx_stat, то указанный used из вывода тоже будет на один больше.

Сейчас, как я выяснил, проблема в том, что env_stat не учитывает stat GC таблицы

Если сплюсовать env.branch_pages+env.leaf_pages+3 и сравнить с mdbx_stat, то указанный used из вывода тоже будет на один больше.

Сейчас, как я выяснил, проблема в том, что env_stat не учитывает stat GC таблицы

17:33

In reply to this message

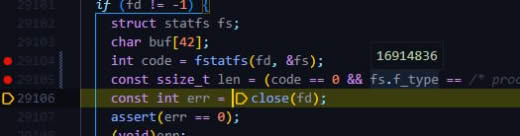

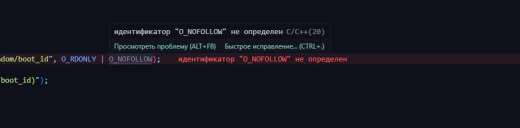

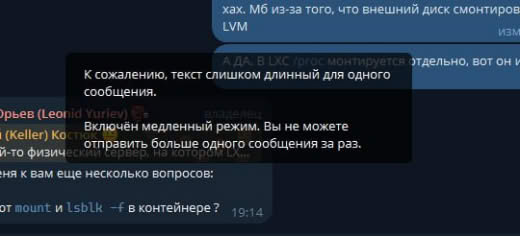

а что за он? Как я могу проверить это?

Такой выдаёт env_info(

Может из-за того, что я бд делал через mdbx_load?

Или потому, что у меня сервер - LXC контейнер?

Такой выдаёт env_info(

Может из-за того, что я бд делал через mdbx_load?

Или потому, что у меня сервер - LXC контейнер?

Л(

17:51

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Не уверен что я понял вас, а вы меня.

Со статистикой использования страниц идея примерно такая:

- есть кол-во распределенных (allocated) страниц, технически внутри структур БД это номер первой не-распределенной страницы.

- можно получить суммарное кол-во страниц используемых корневой таблицей и таблицами пользователя.

- еще есть 3 мета-страницы.

- всё остальное в GC, т.е. разница между распределенными/allocated и используемыми страницами.

При этом предполагается что:

- пользователю нет дела до конкретного содержания GC (сколько страниц в списках внутри GC, а сколько занято под b-tree самой GC).

- при сомнениях что есть потерянные и/или дважды использованные страницы, т.е. сомнениях в целостности БД, следует использовать утилиту mdbx_chk или mdbx_env_chk().

Ничего не мешает добавить в API некую интроспекцию GC, но вопрос — зачем ?

Кроме этого, текущее API в принципе позволяет получить такую информацию в читающих транзакциях, а mdbx_env_chk() предусматривает обратные вызовы на все случаи.

Со статистикой использования страниц идея примерно такая:

- есть кол-во распределенных (allocated) страниц, технически внутри структур БД это номер первой не-распределенной страницы.

- можно получить суммарное кол-во страниц используемых корневой таблицей и таблицами пользователя.

- еще есть 3 мета-страницы.

- всё остальное в GC, т.е. разница между распределенными/allocated и используемыми страницами.

При этом предполагается что:

- пользователю нет дела до конкретного содержания GC (сколько страниц в списках внутри GC, а сколько занято под b-tree самой GC).

- при сомнениях что есть потерянные и/или дважды использованные страницы, т.е. сомнениях в целостности БД, следует использовать утилиту mdbx_chk или mdbx_env_chk().

Ничего не мешает добавить в API некую интроспекцию GC, но вопрос — зачем ?

Кроме этого, текущее API в принципе позволяет получить такую информацию в читающих транзакциях, а mdbx_env_chk() предусматривает обратные вызовы на все случаи.

👌

b

17:53

In reply to this message

Видимо в вашем контейнере не доступен

/proc/sys/kernel/random/boot_id.

АК

Л(

17:56

Леонид Юрьев (Leonid Yuriev)

In reply to this message

Хм, в целом надо разбираться.

Где-то в скриншотах выше было видно что в bootid нули.

А что показывает

Где-то в скриншотах выше было видно что в bootid нули.

А что показывает

mdbx_chk -vv ?

АК

17:57

Алексей (Keller) Костюк 😐

In reply to this message

К сожалению, LMDB оставила очень большую боль с GC... Поэтому мы вынуждены были жёстко считать её, чтобы вовремя отлавливать проблемы. Для этого мы и решили перейти на MDBX.

Но удалять подсчёт не хотелось бы, пока на проде не откатаем

Но удалять подсчёт не хотелось бы, пока на проде не откатаем

17:59

In reply to this message

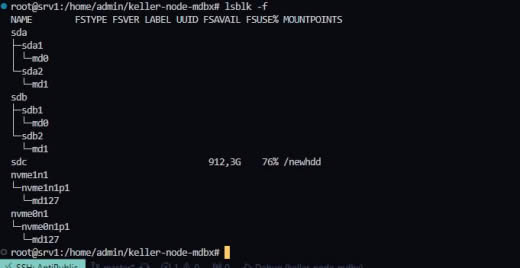

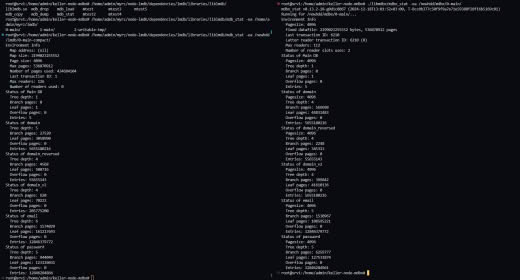

mdbx_chk v0.13.2-0-gb687e835 (2024-12-11T21:51:56+03:00, T-5c7ffd4bbdaaf3578a64afed16bac16f06db2837)

Running for /newhdd/mdbx/0-main/ in 'read-only' mode with verbosity level 2 (of 0..9)...

open-MADV_DONTNEED 290802734..536870912

readahead OFF 0..290802734

- Taking lock... done

dxb-id bfc32c6395f7b13d-2c98e0cf3b384021

current boot-id is unavailable

- Peek the meta-pages...

pagesize 4096 (4096 system), max keysize 1980..2022, max readers 114

mapsize 2199023255552 (2.00 TiB)

fixed datafile: 2199023255552 (2.00 TiB), 536870912 pages

= transactions: recent 1726, latter reader 1726, lag 0

- Traversal B-Trees by txn#1726...

18:00

Остальная инфа явно будет только через день, ибо бд большая :)

Л(

18:03